La vérification des faits actualise, à l’ère des réseaux sociaux des savoir-faire journalistiques. Le fact-checking désigne le processus qui consiste à vérifier l’exactitude d’une ou plusieurs informations en les confrontant à sources fiables, des données factuelles et des preuves concrètes pour en évaluer la validité.Depuis le début des années 2000 aux États-Unis, puis progressivement ailleurs dans le monde, de nombreuses initiatives de fact-checking ont vu le jour : collectifs spécialisés et indépendants ou équipes et rubriques dédiées dans les agences de presse et les médias.

Le Duke University Reporters’ Lab a dénombré plus de 400 rédactions de vérification des faits dans plus de 100 pays en 2023.

Le fact-checking est encadré par des organisations comme l’International Fact-Checking Network (IFCN) et l’’EFCSN, en Europe, qui établissent des standards rigoureux en matière de transparence, d’impartialité et d’indépendance pour les fact-checkers à travers le monde.

La France, par exemple, compte actuellement 9 entités de vérification des faits qui ont adhéré au code de principes de l’International Fact- Checking Network (IFCN). Ao total, en 2023, ces équipes de fact-checking ont procédé à 2024 vérifications.

Selon une enquête, 56 % des Français interrogés trouvent les factcheckeurs utiles car ils aident les citoyens à ne pas croire aux fausses informations. Les jeunes de 18 à 24 ans (65 %) sont plus nombreux à être d’accord avec cette affirmation, tout comme les catégories socioprofessionnelles supérieures (63 %)[1].

Comment le fact-checking parvient-il au public ?

Les entités de fact-checking assurent elles même la diffusion de leur production : via des sites web pour les agences indépendantes, via des rubriques et des espaces dédiés au fact-checking, dotées d’une identité propre, dans les publications des agences de presse et les médias d’information. Avec une présence sur les réseaux sociaux.

A partir de 2016, sous la pression des gouvernements et des sociétés civiles, la plupart des plateformes ont annoncé qu’elles travaillaient désormais à limiter la création et le partage de fausses informations. Outre le développent d’algorithmes pour supprimer les comptes multiples et pour détecter les opérations coordonnées (fermes à trolls, bots), les plateformes se sont engagées à réduire la portée et à freiner la circulation des fausses informations qui leur étaient signalées ou qu’elles avaient détectées elles-mêmes : elles ont aussi ont entrepris de donner de la visibilité aux « vérifications » réalisées par les fact-checkeurs.

Google a apporté en 2017 des modifications à son moteur de recherche en vue de limiter la visibilité des fausses informations. Cet ajustement impactait l’ordre des résultats proposés sur le moteur de recherche, mais aussi les condensés d’information que le moteur propose aux internautes sous forme d’encadré. La fonction « À propos de ce résultat » permet d’obtenir des informations sur un site internet. La fonction « À propos de cette image » permet de vérifier l’arrière-plan et le contexte des images vues en ligne. GoogleSearch s’appuie sur outil, ClaimReview, pour prioriser les articles de vérification dans ses résultats. Google, en outre, met à la disposition des journalistes et des vérificateurs de faits une base de données, Fact Check Explorer.

Meta a conclu, en 2016, des partenariats avec des fact-checkeurs qui examinent et évaluent les informations suspectes. Cette vérification donne lieu à la publication d’un avertissement qui donne aux utilisateurs le contexte d’une information évaluée comme trompeuse, avec un lien vers la vérification des faits, ainsi qu’a une limitation algorithmique de leur diffusion, « afin qu’il soit vu par moins de personnes » [2].

L’efficacité de ces mesures fait l’objet de nombreuses études, aux résultats contradictoires. Les « disinformation studies » ont littéralement explosé, principalement aux Etats-Unis. Ces études portent principalement sur la capacité du fact-checking à influer sur les croyances mais plus rarement sur l’efficacité des dispositifs mis en place par les plateformes pour donner de la visibilité au fact-checking et encore moins sur leur impact en termes de comportements : les utilisateurs sont-ils plus susceptibles d’ignorer le contenu signalé que de le lire et de le partager ? Les plateformes détiennent les données pour le savoir : Facebook indique ainsi que 46 % des utilisateurs de l’UE qui ont vu l’avertissement ont choisi de ne pas le partager. Après avoir mis un certain nombre de données à la disposition des chercheurs, les plateformes ont, une à une, cessé de le faire. C’est un des enjeux du Digital Services Act, que d’obtenir pour les chercheurs un accès aux données.

« D’importantes lacunes dans les efforts actuels des plateformes »

Pour avoir une idée de la capacite des plateformes à donner de la visibilité à la production des fact-checkers, il faut dépouiller les rapports qui évaluent la manière dont les plateformes mettent en œuvre les engagements qu’elles ont prises, en 2018, dans le cadre du Code européen de bonnes pratiques de l’UE contre la désinformation.

L’European Fact-Checking Standards Network (EFCSN), dans un rapport récent, pointe « d’importantes lacunes dans les efforts actuels des plateformes ».

- S’agissant de Google Search, son système (ClaimReview) « ne remplit pas son engagement de « couverture complète de tous les États membres et de toutes les langues ». Les rapports de Google révèlent que dans sept langues, aucune vérification n’est actuellement disponible et que dans une langue, le nombre de vérifications disponibles a même diminué au fil du temps » . Google, par ailleurs, ne propose aucune compensation financière pour les efforts des fact-checkers.

- « YouTube a cessé de fournir des informations sur les organisations de fact-checking impliquées dans son programme de partenariat, qui répertoriait auparavant les organisations partenaires de pays non-membres de l’UE comme étant organisations de fact-checking basées dans l’UE »

- « Instagram affiche toujours beaucoup moins de labels de vérification des faits que Facebook, malgré l’accès aux mêmes vérifications. Cela suggère soit des problèmes d’accès aux données pour les vérificateurs de faits, soit des systèmes de mise à l’échelle inadéquats au sein de Meta ».

- « WhatsApp n’a montré aucun progrès au cours des deux dernières périodes de rapport concernant les engagements signés, malgré son rôle crucial dans la diffusion de la désinformation en ligne ».

- « Bing (via Microsoft) a fait état d’une « couverture supplémentaire de vérification des faits » avec des organisations qui ont refusé de conclure des accords en ce sens. L’EFCSN estime que Microsoft ne respecte pas son engagement de coopérer avec la communauté des vérificateurs de faits ».

- « LinkedIn s’appuie toujours sur une seule organisation de vérification des faits pour couvrir 21 langues et une plus grande transparence est nécessaire sur le cadre de ces accords. Malgré les affirmations d’élargissement de la portée géographique, le nombre de vidéos examinées a diminué de plus de 80 % par rapport à l’année précédente ».

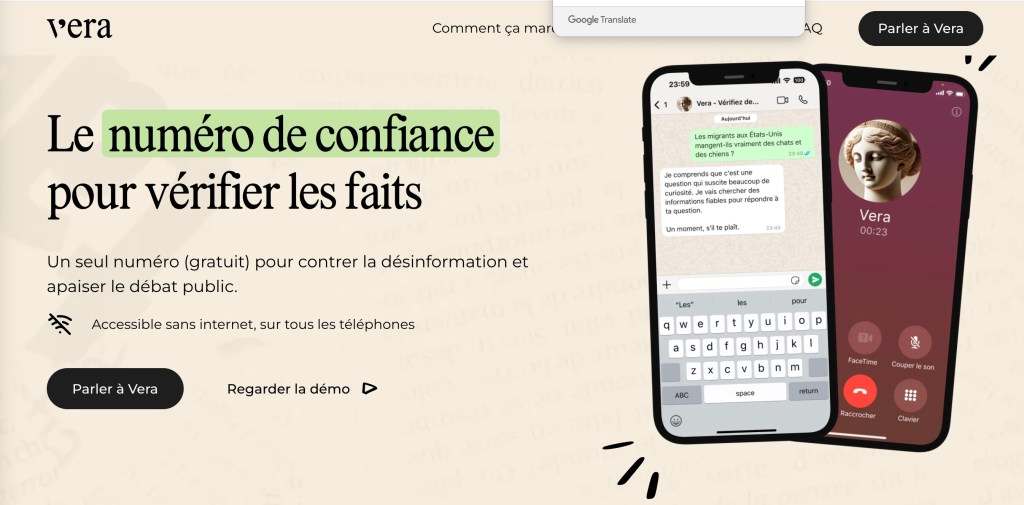

Vera : assistant vocal aidé par l’IA, pour vérifier rapidement une information

Dans quelle mesure est-il possible de permettre au public de vérifier une information par lui-même, sans dépendre des dispositifs mis en place par les plateformes, dispositifs dont on a vu, plus haut, les limites ? Cette question revêt une actualité particulière, suite à la décision récente de Meta de mettre fin à son programme de vérification des faits.[3]

Avec le projet Vera, LaReponse.tech s’est donné l’objectif de mettre les ressources du fact-checking à la disposition du public : en composant un numéro de téléphone gratuit ou via un message WhatsApp.

Vera n’a pas la capacité, par elle-même, de dire le vrai et le faux. Vera s’assure, face à un « fait » qui lui est rapporté, face à une information qui lui est soumise (un propos tenu, un chiffre, un évènement) que cette information a déjà été examinée (validée, nuancée ou invalidée) par une ou des équipes de fact-checking (« vérificateurs de faits ») ou qu’elle est vérifiable, en consultant des sources de référence, réputées sérieuses et fiables : ce propos a-t-il été tenu ? A-t-il été déformé ? Ou extrait de son contexte ? Cet évènement s’est-il produit ? Ce chiffre est-il solide et vérifiable ?

Si l’information qui est soumise n’a jamais été examinée ou si elle est invérifiable, Vera indique « Je n’ai pas trouvé de sources fiables qui confirment cette information ».

La version Whatsapp de Vera ne se contente pas de commenter l’information qui lui est soumise : elle propose, a l’appui de son commentaire, une et souvent plusieurs sources, sous forme de liens. En ce sens, Vera contribue à faire connaitre et valorise le travail des factcheckeurs et des journalistes.

Vera utilise l’intelligence artificielle GPT-4 pour analyser les questions. L’assistant ne balaye pas l’ensemble du web (comme le font les moteurs de recherche) mais se concentre sur une centaine de sites spécialisés dans la vérification des faits : des agences indépendantes et des équipes de fact-checking adossées à des médias. Ces équipes de fact-checking sont signataires du code de principes de l’IFCN (International Fact-Checking Network) ou celui de son homologue européen, l’EFCSN.

Vera s’appuie, en outre, sur plus de 250 sources de référence (agences de presse, journaux, radios, télévisions, presse en ligne) réputées, dans chaque pays, pour le sérieux de leur couverture de l’actualité et leur indépendance. Leur sélection, leur évaluation et l’ajout de nouvelles sources sont un processus continu.

[1] Guillaume Caline Laurence_Vardaxoglou, Verian: Public opinion about the fight against mis- and disinformation, 2024

[2] X (Twitter) n’est pas signataire de ce code. X ne s’appuie sur des factcheckeurs mais sur ses propres utilisateurs pour identifier les fausses informations par le biais des Community Notes (ex-Birdwatch) . Les contributeurs peuvent ajouter du contexte, ou porter un jugement dans un encart placé sous une publication, une image ou une vidéo. Il revient à un algorithme de notation de faire le tri. Plus une note reçoit le soutien de personnes qui ont été en désaccord par le passé, plus elle a de chances d’être publiée. Des études convergentes montrent que les notes communautaires ont encore moins d’effets et potentiellement plus de biais que le fact-checking, notamment parce qu’elles sont ajoutées dans des délais trop distants des pics d’audiences des publications et qu’elles sont bien plus souvent écartées que publiées. Meta prévoit de remplacer son programme de fact-checking par un système de notes communautaires inspiré de celui de X.

Yuwei Chuai, Haoye Tian, Nicolas Pröllochs, Gabriele Lenzini : Did the Roll-Out of Community Notes Reduce Engagement With Misinformation on X/Twitter?

[3] Meta prévoit de remplacer son programme de fact-checking par un système de notes communautaires inspiré de celui de X. X ne s’appuie sur des factcheckeurs mais sur ses propres utilisateurs pour identifier les fausses informations par le biais des Community Notes (ex-Birdwatch) . Les contributeurs peuvent ajouter du contexte, ou porter un jugement dans un encart placé sous une publication, une image ou une vidéo. Il revient à un algorithme de notation de faire le tri. Plus une note reçoit le soutien de personnes qui ont été en désaccord par le passé, plus elle a de chances d’être publiée. Des études convergentes montrent que les notes communautaires ont encore moins d’effets et potentiellement plus de biais que le fact-checking, notamment parce qu’elles sont ajoutées dans des délais trop distants des pics d’audiences des publications et qu’elles sont bien plus souvent écartées que publiées. Yuwei Chuai, Haoye Tian, Nicolas Pröllochs, Gabriele Lenzini : Did the Roll-Out of Community Notes Reduce Engagement With Misinformation on X/Twitter?