Extrait de l’étude réalisée par Items à la demande du Ministère de l’Intérieur. Confidentielle, cette étude a fait l’objet d’une demande d’accés au titre de la loi de 1978 par l’Association de Promotion du Logiciel Libre (APRIl). Elle est disponible sur le site de l’APRIL.

LES LOGICIELS LIBRES METTENT SOUS TENSION CONCURRENTIELLE LES MARCHES DU LOGICIEL

Les solutions libres sont plus en plus reconnues et admises dans les organisations 59 publiques et privées. Les acteurs du marché (éditeurs, intégrateurs, utilisateurs) intègrent ce modèle de développement dans leurs stratégies.

Si le logiciel libre suscite encore aujourd’hui des controverses, celles-ci sont de nature essentiellement technique et économique.

Internet avait rencontré, lui aussi, des oppositions, il y a 10 ans, et suscité des controverses. La question d’être pour ou contre internet ne se pose plus.

Il est assez largement admis que les logiciels libres redessinent aujourd’hui le cadre concurrentiel dans les secteurs de l’informatique, des télécommunications et de l’électronique grand public :

• Les constructeurs et les éditeurs diffusent de manière libre certains composants de leur offre afin que ceux-ci se diffusent de la manière la plus large auprès des utilisateurs. C’est par exemple la stratégie de Sun avec un grand nombre de composants Java. (C’est aussi d’une certain manière la stratégie de Microsoft avec Explorer, même si dans ce cas précis, il ne s’agit que d’une licence d’utilisation gratuite[1]).

• Les acteurs non dominants sur un marché recourent aux logiciels libres pour concurrencer l’acteur ou les acteurs dominants, non pas en l’attaquent frontalement mais en s’appuyant sur des communautés libres qui vont favoriser l’émergence de solutions concurrentes,

• Les intégrateurs favorisent le développement de solutions libres pour restaurer leur indépendance vis-à-vis des éditeurs et redevenir l’interlocuteur principal des organisations utilisatrices.

• Des sociétés de services en logiciels libres centrent leurs activités sur la valeur ajoutée en proposant des applications complémentaires, des formations, de l’assistance, etc.

L’économie des logiciels libres s’insère donc dans l’économie générale des logiciels tout en présentant des particularités.

Elle repose largement sur la fourniture de services notamment de maintenance autour des progiciels ou la création, plus embryonnaire, de logiciels sur mesure en utilisant des briques logicielles qui existent déjà.

Dans de nombreux secteurs, le logiciel libre ouvre la concurrence, contribue à

« déverrouiller » les marchés, fait peser sur les éditeurs historiques une pression concurrentielle qui s’était considérablement atténuée.

LOGICIELS LIBRES ET COMMUNAUTES

Basé souvent sur un développement communautaire, le logiciel libre requiert :

• Un nombre assez large de développeurs

• La stabilité de la communauté de développement,

• Un intérêt de cette communauté à faire évoluer de manière continue un logiciel à la fois pour l’enrichir et pour résoudre les problèmes de fonctionnement.

Les modèles de développement libres concernent trois grands types d’environnement distincts

• le système d’exploitation (LINUX) et les couches techniques intermédiaires (Middleware)

• les logiciels applicatifs bureautique

• les logiciels fonctionnels

Le système d’exploitation (LINUX) et les plateformes Middlewares

Le Système d’exploitation

C’est le composant le plus emblématique mais qui peine encore à pénétrer le marché. Très présent sur les serveurs de réseaux, LINUX n’est présent aujourd’hui que sur 3% des postes de travail.

Les couches techniques intermédiaires (Middleware)

C’est pour le monde des professionnels, le secteur où les logiciels libres sont les plus répandus. Ce n’est pas le secteur le plus visible, mais c’est là que se développent les stratégies les plus abouties dans la compétition que se livrent les constructeurs, les éditeurs de logiciel, les intégrateurs et plus largement tous les acteurs du numérique.

Ainsi, les serveurs web avec les plateformes Apache occupent aujourd’hui une place dominante.

C’est avec notamment le soutien de Sun et d’IBM que se sont imposées des couches techniques autour des environnements Java.

Les déclinaisons de ces composants sont nombreuses et sont largement utilisées par l’industrie.

Ceci n’empêche pas les acteurs du marché de développer des stratégies propres. C’est le cas de Sun ou d’IBM qui promeuvent des composants libres tout en déployant des stratégies plus propriétaires sur d’autres composants ou produits.

Microsoft est naturellement très actif sur ces couches techniques en s’appuyant sur .net.

Les logiciels bureautiques

C’est la vitrine la plus visible des logiciels libres. Alors que la Version 1 de la Suite

OpenOffice.org était relativement pauvre et présentait beaucoup de lacunes face à Microsoft Office, la Version 2 se montre beaucoup plus riche. Si elle n’égale pas Microsoft Office, ses adeptes considèrent que les utilisateurs ne font pas appel à des fonctionnalités spéciales dont ne disposerait pas OpenOffice.

Deux problèmes se posent couramment pour l’usage d’OpenOffice :

– Les problèmes de compatibilité subsistant avec Microsoft Office et qui rendent parfois difficiles les échanges de documents dans un mode de travail collaboratif. Certaines fonctions telles que la gestion des titres ou celle des images se manifestent par des différences dans le document final. Ce problème n’est en réalité pas un problème de logiciel mais un problème de format. Il est au centre de la bataille que se livrent les tenants du format ODF (Open Document Format) normalisé par OASIS, et de l’autre, Microsoft qui souhaite voir les autorités de normalisation consacrer son propre format connu sous le nom d’Open XML comme une norme internationale.

– L’existence de clients lourds liés à Microsoft Office et qui ne peuvent être repris sous OpenOffice. De nombreuses applications dans les entreprises et les administrations (et notamment au Ministère de l’Intérieur) utilisent en effet des fonctions liées au traitement de document, aux tableurs ou aux bases de données locales Microsoft.

Les logiciels fonctionnels : les applications

Ces logiciels répondent généralement à des besoins précis des utilisateurs pour les fonctions de gestion des entreprises.

L’idée selon laquelle un logiciel développé pour un utilisateur ou un contexte précis pourrait être réutilisé par d’autres utilisateurs est au principe même du logiciel libre. S’agissant d’applications fonctionnelles, cette perspective de réutilisation et de mutualisation sous-estime généralement l’effort qu’il faudra ensuite consentir pour adapter ces logiciels à une organisation spécifique, son contexte, son métier et ses processus. Elle sous-estime l’ampleur des efforts que représente l’industrialisation d’un logiciel pour qu’il puisse être utilisé par de nombreux utilisateurs dans des contextes différents.

Ce problème n’est pas spécifique aux logiciels libres. Les sociétés de service (les intégrateurs) ont été confrontées, de tous temps, à cette question de manière récurrente : pourquoi ne pas industrialiser des solutions conçues pour un client spécifique, en étendre le périmètre, les proposer à d’autres clients et en tirer un bénéfice multiplicateur ? Il semble bien que les métiers de l’édition (une solution « industrialisée » pour un grand nombre de clients) et ceux du service (une solution sur mesure) soient de nature différente.

Verra-t-on des solutions Open Source prendre pied et s’imposer sur le marché des logiciels fonctionnels, domaine de prédilection des éditeurs ?

A en juger par la répartition des communautés de développements de logiciel Open Source (telle qu’elle apparaît dans SourceForge, qui regroupe au niveau mondial le plus grand nombre de ces communautés), les communautés du logiciel libre sont très actives dans le développement d’applications et de logiciels fonctionnels.

Les communautés les plus actives travaillent notamment sur un progiciel de gestion intégré (OpenBravo ERP) capable de concurrencer SAP. Un grand nombre de sociétés de services et d’utilisateurs sont potentiellement intéressés à rouvrir la concurrence dans ce secteur. Les développeurs dans ces communautés parviendront-ils à se concentrer durablement sur leurs objectifs ? Ne risquent ils pas de s’en détourner si un nouveau sujet présente plus d’intérêt à leurs yeux ?

PARTICIPATION DES ADMINISTRATIONS A DES COMMUNAUTES

Les projets de logiciels libres, pour les administrations, sont de trois types, auxquels sont associés, trois types de risques :

• Les projets de logiciels45 [2]préexistants, bien établis, correspondant à un besoin largement partagé. Les développeurs dans les administrations participent à ces projets dans le cadre de communautés (sans que ce soit toujours clairement géré).

Sur le fond, on peut estimer que l’administration y trouve son compte, pour autant que le temps passé soit en relation avec des objectifs définis.

• Les projets initiés par une administration et pour lesquels l’administration souhaite voir émerger une communauté qui garantira, dans la durée, la pérennité et l’évolutivité du logiciel. C’est ce qu’à très bien réussi la Gendarmerie avec OCS Inventory pour la gestion du parc informatique. La réussite de telles démarches, c’est à dire le maintien d’une communauté, reste incertaine.[3]

• Les projets de logiciel initiés par une administration et dont les résultats pourraient être repris par une autre. Ce cas de figure est récurrent.47 Il n’est pas directement lié à la question du logiciel libre. Il semble bien que les licences libres apportent une réponse simple à cette exigence de partage entre les administrations. Encore faut-il pouvoir introduire cette clause dans les CCAG des marchés publics. Le résultat reviendrait à constituer une « communauté ad-hoc ».

Le problème s’est posé pour la plateforme d’achat public développée pour le Ministère de la Défense par CapGemini Sogeti. Le Ministère de la Défense souhaitait mettre cette plateforme à la disposition d’autres Ministères. Le ministère de la défense et les autres ministères se sont aperçus que le contrat ne prévoyait pas une telle mise à disposition. Ces ministères ont du se tourner dans l’urgence vers une autre solution.

INDUSTRIALISATION ET INDEPENDANCE

Les années 80 et 90 ont été marquées par une montée en puissance des progiciels aux dépens des développements spécifiques.

L’attractivité des logiciels proposés par les éditeurs repose sur leur niveau d’industrialisation. Celle-ci comprend une gestion rigoureuse des niveaux de version, un support technique par niveau de version des problèmes identifiés, des engagements contractuels des fournisseurs.

L’utilisation des logiciels libres dans les grandes organisations appelle la mise au point d’offres professionnelles structurées. S’agit-il uniquement de contrat de services ? Ces contrats incluent-ils une forme de responsabilité sur la fourniture des « souches logicielles » ?

La difficulté des éditeurs et des sociétés de services spécialisées dans les logiciels libres à proposer ce type d’offres incite les grands comptes à se tourner vers des fournisseurs de plateformes qui offrent une gamme de logiciels « packagés ». Ce faisant, contrairement à des objectifs initiaux clairement affirmés, des liens de dépendance se recréent ainsi entre fournisseurs de logiciels libres et utilisateurs.

Les problématiques d’indépendance et de dépendances peuvent s’avérer plus complexes qu’il n’y paraît.

La dépendance a un coût : celui qui est du à un appauvrissement de la concurrence des acteurs face à un besoin exprimé par le client. Comme veut le montrer le schéma précédent, cette dépendance peut venir des logiciels propriétaires. Elle peut également venir de la relation qui va s’établir avec les sociétés de services qu’elles s’appuient sur du logiciel libre ou non.

L’indépendance a également un coût. Le recours systématique au libre et surtout s’il est non packagé, oblige l’organisation utilisatrice à prévoir et organiser le support et une forme d’ «industrialisation » des logiciels. L’indépendance suppose une organisation suffisamment bien structurée pour que cela n’aboutisse pas à une multiplication des solutions.

On remarquera que les normes et standards ne sont pas liés en soit au sujet libre ou propriétaire. Ainsi les acteurs du marché sont-ils présents dans différentes structures de normalisation, lesquelles travaillent non pas sur des composants logiciels (parfois appelés à tort standards), mais sur des interfaces, des protocoles ou des formats. Ces standards peuvent donner lieu à des licences d’utilisation gratuites (c’est le cas des standards du W3C) ou payantes (c’est le cas de la plupart des organisations de standardisation comme l’ETSI où la règle qui retenue est celle dénommée FRAND (Fair Reasonnable And Non Discriminatory).

Il y a plusieurs manières de faire valoir les avantages ou inconvénients des différentes offres dans ce débat. Les acteurs du marché (intervenant dans le secteur libre ou propriétaire) ne s’en privent pas : c’est en fait un élément central du nouveau jeu concurrentiel.

Ce jeu est loin d’être manichéen. Il fonctionne juste avec des règles différentes dont le débat sur le libre devient le moteur et dont le débat sur les standards devient le pivot.

[1] Microsoft a trois types de licences présentées comme libres. Deux ont été acceptées par l’Open Software Alliance : MSPL (Microsoft Permissive License) et MSRL (Microsoft Reciprocal License).

[2] On désigne ces projets de plus en plus souvent comme des « souches logicielles »

[3] Une démarche intermédiaire pourrait être au niveau national de disposer d’une structure d’animation de ces communautés émergentes. Ce rôle pourrait être dévolu à la DGME. C’est le but qu’elle s’est fixée avec Admisource. De sorte qu’on pourra différencier deux sous-catégories : le lancement de communautés « sans frontières » et le lancement de communautés dans un environnement national sous la bannière d’Admisource.

Denis Olivennes s’etait engagé à formuler de propositions qui tiennent en une page A4. Le pari est tenu avec 13 propositions (même si le rapport totalise 110 000 signes, majoritairement focalisées sur l’examen des différentes technologies de filtrage).

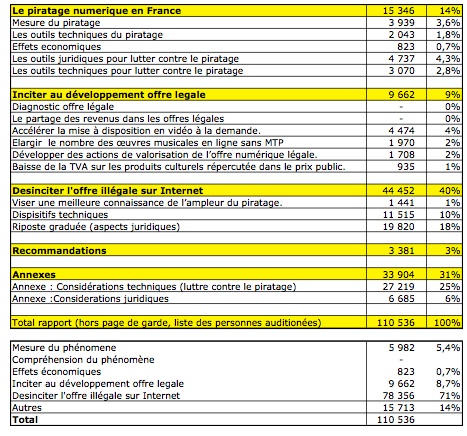

Denis Olivennes s’etait engagé à formuler de propositions qui tiennent en une page A4. Le pari est tenu avec 13 propositions (même si le rapport totalise 110 000 signes, majoritairement focalisées sur l’examen des différentes technologies de filtrage). Le Rapport Olivennes ne consacre que 3939 signes (3,6% du total) à la mesure des pratiques de téléchargement et de partage sur les réseaux pair à pair.

Le Rapport Olivennes ne consacre que 3939 signes (3,6% du total) à la mesure des pratiques de téléchargement et de partage sur les réseaux pair à pair.

Les accords de Grenelle ont été négociés et conclus pendant Mai 1968 au siège du ministère du Travail français situé rue de Grenelle.

Les accords de Grenelle ont été négociés et conclus pendant Mai 1968 au siège du ministère du Travail français situé rue de Grenelle.